Как избежать блокировки СSS и JavaScript

Если вы по специальности веб-мастер, то вы вероятно уже сталкивались с таким сообщением ”Googlebot не может обращаться к CSS и файлам JavaScrip на сайте”. Затем в прошлом году Google внес значительные изменения в своих принципах роботы для веб-мастеров, добавив примечание: “ Запрет искать Javascript или CSS файлы в файле robots.txt вашего сайта напрямую вредит алгоритмам визуализации, индексированию содержания, а также может привести к снижению позиции в рейтинге поисковых систем”.

Также к вашему вниманию CSS-фреймворки для адаптивного веб-дизайна подробно.

В связи с этим спешим вам сообщить, что недавно стал доступным новый, бесплатный инструмент Fetch от Googlebot, в котором есть все, что нужно для роботы с robots.txt. Файл robots.txt это файл, который содержится в корневом каталоге сайта, и в котором следует указать какие данные и страницы не следует индексировать. Файл содержит директивы, описывающие доступ к разделам сайта.

Инструмент Fetch достаточно хорош, но пока еще не имеет возможности решить все проблемы связанные с СЕО и robots.txt. Для использования данного инструмента вам необходимо:

- иметь свой гугл аккаунт;

- пройти верификацию - (подтвердить, что веб-сайт принадлежит именно вам);

- robots.txt может тестироваться только с использованием Googlebot;

- отключить опцию проверки карты сайта.

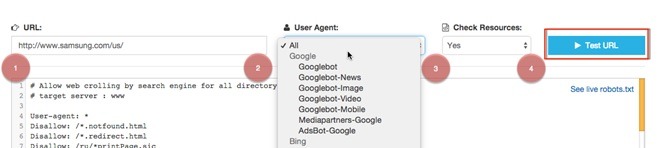

Для простоты управления тестовым инструментом - robots.txt

- Введите названия сайта и robots.txt

- Определите пользователя или группу, на которой хотите выполнить проверку

- В окне проверка ресурсов выберете “Да”

- Нажмите кнопку начать тестирование.

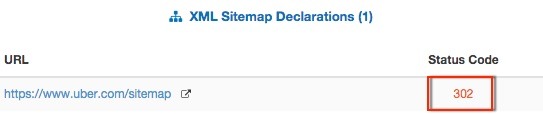

Прокручивая XML карту сайта и разделы User Agenе, вы увидите:

- CSS и JavaScript ресурсы перечисленные вместе с кодом статуса

- код статуса может используваться или не используваться

- ресурсы домена

- ссылку к актуальному robots.txt файлу

Ниже наведен пример с сайта kuhl.com, который имеет ресурс JavaScript, запрещенную в robots.txt на static.criteo.net .

Основы robots.txt тестирования и проверки карты сайта

Часто возникает потребность в проверки URL на блокировку в директории robots.txt. Инструмент Fetch делает шаг вперед , проверяя URL в вопрос в отношении любого Агента пользователя, указанного в файле robots.txt .

Например, сайт samsung.com заблокирован в Yandex для сканирования пользователей из США.

Также любая XML карта сайта в robots.txt директории проверяется на доступность для поисковых механизмов.

Следует также отметить, что когда вы начинаете искать robots.txt тест, большинство результатов покажут, что вам следует обновить сайт или сделать его редизайн.

О карте сайта как инструменте повышения эффективности SEO продвижения в предыдущей статье описано более детально.

Перевод материала с сайта searchenginewatch.com.